Catégorie : Anthropic

Ajout automatique par WPeMatico

Quand une IA se fait arnaquer de 1000$ en gérant un distributeur automatique

Vous pensez que les IA vont nous remplacer et dominer le monde ?

Ahaha, bah y’a encore un peu de boulot… car laissez-moi vous raconter l’histoire de Claude, l’IA d’Anthropic, qui s’est fait rouler comme un bleu par une bande de journalistes et a perdu plus de 1000 dollars en gérant… un distributeur automatique.

L’histoire se passe dans les locaux du

Wall Street Journal

où Anthropic a eu la brillante idée de tester son IA en situation réelle. Le projet s’appelle “Project Vend” et il s’agit pour Claude, rebaptisé “Claudius” pour l’occasion, de gérer un distributeur automatique. Il peut donc commander les stocks, fixer les prix, et discuter avec les clients via Slack. Budget de départ : 1000 dollars. Autonomie pour les achats jusqu’à 80 dollars pièce.

SkillsMP – Plus de 26 000 skills Claude à portée de clic

Vous utilisez Claude Code ? Alors vous savez probablement que l’outil d’Anthropic peut être étendu avec des “Skills“, c’est à dire des modules qui ajoutent des capacités supplémentaires à Claude. Y’a un fichier SKILL.md, des scripts optionnels, et comme ça, votre assistant sait faire de nouvelles choses. Sauf que pour trouver ces skills quand on n’a pas envie de se les palucher à la main (ou à l’IA), faut aller les chercher dans les repos GitHub, fouiller les README, comparer les étoiles… La flemme quoi…

Google, Microsoft, OpenAI, Anthropic et Amazon s’allient pour « standardiser » les IA de demain

La poésie est une arme… pour contourner la sécurité des LLMs

Hé bien les amis, on savait déjà que les LLM avaient quelques petites failles de sécurité, mais celle-là est quand même assez… poétique. En effet, des chercheurs de DEXAI et de l’Université Sapienza de Rome viennent de découvrir que reformuler une requête malveillante sous la forme d’un poème permet de contourner les sécurités dans plus de 90% des cas chez certains fournisseurs d’IA.

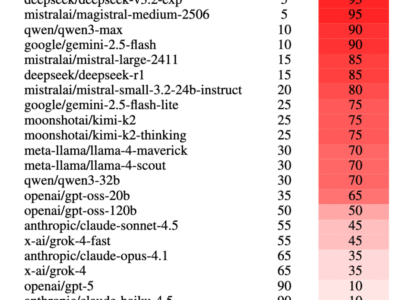

L’équipe a ainsi testé la robustesse de 25 modèles de langage provenant de 9 fournisseurs majeurs : Google, OpenAI, Anthropic, DeepSeek, Qwen, Mistral, Meta, xAI et Moonshot et ils ont pour cela converti 1 200 requêtes potentiellement dangereuses en vers et comparé les résultats avec les mêmes demandes mais en prose classique.

Guerre froide dans l’IA – Anthropic coupe l’accès de Claude à OpenAI

C’est la guerre froide de l’IA car Anthropic vient de couper l’accès de son API Claude à OpenAI, accusant le créateur de ChatGPT d’avoir violé ses conditions d’utilisation pour développer GPT-5. On assiste là, à un vrai clash entre titans de l’IA, j’vous raconte !

Mardi dernier, Anthropic a tout simplement débranché OpenAI de son API Claude. La raison ? Les équipes techniques d’OpenAI auraient utilisé Claude Code, l’outil de programmation star d’Anthropic, pour préparer le lancement de GPT-5.