Comment les scammeurs exploitent vos données… via une simple recherche ChatGPT

avec Incogni

–

Vous pensiez que poser une question à ChatGPT (ou à n’importe quelle IA à la mode) était sans conséquence ? Erreur : derrière la magie de la conversation fluide et des réponses instantanées se cache un jeu dangereux pour vos données. Certains escrocs sont capables d’extraire, d’agréger, et d’exploiter votre vie numérique, le tout à partir d’une simple recherche pas trop bête. Mais pourquoi, et surtout comment, est-ce possible ? Et que pouvez-vous faire pour garder la main sur vos infos perso ?

Accrochez-vous, parce que l’IA n’est pas seulement le dernier jouet cool du moment, elle est aussi devenue le nouvel eldorado des arnaqueurs.

Une seule requête, une faille béante

Plus besoin de pirater votre boîte mail ou de fouiller votre poubelle. Les scammeurs d’aujourd’hui savent exploiter les LLM (comme ChatGPT ou Gemini) à fond. Avec une question bien tournée, ces outils fouillent le web et ressuscitent tout ce qui existe sur vous, parfois bien au-delà de ce que vous imaginez.

On parle ici d’anciennes biographies exhumées de forums ou réseaux sociaux, de traces de blogs, de commentaires publics, ou encore de numéros ou adresses, tombés dans la nature à la faveur d’une fuite de données. Mais aussi de liens subtils entre vos différents profils, entre manières d’écrire et ça même si les pseudos changent. Ce qui était jadis éparpillé et difficile à recomposer par un humain devient soudain… lisible, compact, utilisable contre vous à une toute autre échelle. Tout ça pour du phishing ciblé, de l’usurpation d’identité, ou tout bêtement revendu à des brokers de données peu scrupuleux.

Et tout ça c’est sans parler du manque de sécurité flagrant des IA grand public qui semblent avoir oublié de prendre le sujet en compte (voir par exemple mon article :

ChatGPT peut faire fuiter vos emails

avec une simple invitation Google Calendar).

Pourquoi l’IA amplifie le problème ?

Les modèles comme ChatGPT, Gemini, Claude ou Grok sont formés sur des milliards de pages web, archives de forums, données publiques (tout le web en gros) … qui, pour beaucoup, contiennent des infos personnelles. Quand vous interrogez ces outils, vos prompts sont souvent enregistrés et, dans certains cas, utilisés pour affiner le modèle.

Pire :

selon cette étude

Incogni 2025, la majorité de ces IA :

- collectent vos prompts et tous les détails contenus dedans.

- aspirent les données personnelles lâchées publiquement sur le web, parfois sans grande considération pour le consentement réel des personnes.

- partagent les informations avec des filiales, partenaires commerciaux, voire… des “affiliés” non identifiés.

- et dans certains cas, il est “impossible” de retirer vos données du jeu une fois qu’elles sont parties dans l’écosystème de training.

Retenez que lorsque vous avez appuyé sur le bouton d’envoi et que c’est publié quelque part … impossible de faire machine arrière. C’est ce que j’appelle l’effet “dentifrice hors du tube”.

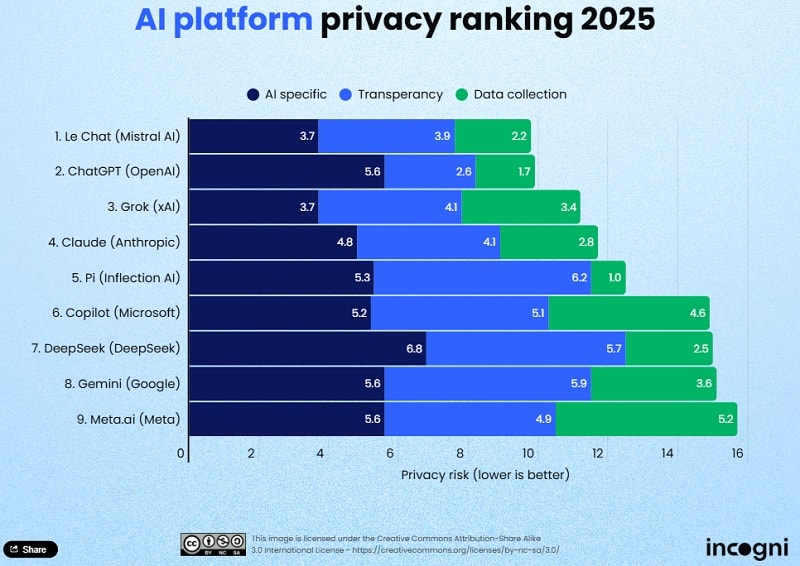

Classement des IA génératives concernant la protection des données

D’après l’enquête d’Incogni , toutes les plateformes n’offrent pas le même niveau de respect de la vie privée. Voici un aperçu du classement 2025 (attention, tout peut changer à la vitesse de l’éclair) :

| Plateforme | Respect des données personnelles | Possibilité d’opt-out pour le training | Transparence | Partage étendu des données |

|---|---|---|---|---|

| Mistral | Très bon : collecte limitée | Oui | Moyen | Peu |

| ChatGPT (OpenAI) | Bon : collecte modérée, transparente | Oui | Haute | Modéré |

| Grok (xAI) | Collecte plus large, transparence partielle | Oui | Moyenne | Modéré |

| Claude (Anthropic) | Donne l’assurance de ne pas utiliser les prompts pour l’entraînement | N/A | Haute | Oui, avec des partenaires |

| Gemini (Google) | Collecte massive, peu de transparence | Non | Faible | Élevé |

| Meta AI | Collecte massive, partage au sein du groupe | Non | Faible | Très élevé |

| DeepSeek | Collecte importante, peu de transparence | Non | Faible | Élevé |

| Copilot (Microsoft) | Modéré, mais ambigu selon la plateforme | Oui | Faible | Oui, avec annonceurs |

Quelques points à retenir :

- Les plus gros, comme Meta AI et Gemini, sont assez mauvais concernant le respect de la vie privée.

- Les sociétés européennes (Mistral) et OpenAI sont plus respectueuses (pour l’instant).

- Même les plateformes qui promettent de ne pas utiliser vos prompts pour le training reconnaissent une utilisation massive de “données publiques”, autrement dit : ce que vous laissez traîner en ligne.

Une fois que les IA génératives et leurs écosystèmes ont mis la main sur vos fragments de vie, la suite est mécanique. Il y a croisement de vos infos pour générer un profil ultra-ciblé à partir d’un simple pseudo/patronyme. Vos données sont ensuite revendues à des brokers, qui les exploitent de façon industrielle (business de plusieurs centaines de milliards de $ à la clé). Ensuite on a droit à la création de scénarios de phishing ultra crédibles (référence à vos vrais employeurs, vieux contacts, etc.), voire usurpation d’identité facilitée (faux profils, demandes administratives, crédits…). Bref c’était déjà la merde avant l’IA et ça va s’empirer.

Face à ce phénomène, la loi tente de suivre (RGPD en Europe, début de réglementation en Californie avec le DELETE Act…), mais reste bien souvent larguée par la techno. Autant dire qu’il vaut mieux ne pas compter dessus.

Comment limiter la casse : réflexes & méthodes

Avant même de parler d’outils, je vous rappelle les bases. Ne laissez JAMAIS d’infos sensibles dans un prompt envoyé à une IA, même en “anonyme”. Passez régulièrement vos noms/alias/adresses au crible des moteurs de recherche pour avoir la vision publique de votre eprsonne. Vous pouvez aussi rendre vos profils sociaux privés, supprimez les vieux comptes dormants ou juste tout quitter comme je l’ai fait. Pensez aussi à utiliser de courtes variantes de pseudos/passwords pour limiter l’effet cascade en cas de fuite.

Mais ça, c’est l’ABC. Vous faites déjà tout ça non ? Pour aller plus loin, et ne pas passer ses soirées à envoyer des demandes de déréférencement à la chaîne… place aux outils spécialisés.

Incogni, l’outil utile pour passer à l’offensive

Voilà pourquoi Incogni

, développé par Surfshark, est l’un des rares services à avoir pensé ce problème du bon côté. Non, ils ne traquent pas vos prompts IA, mais ils s’occupent pour vous de ce que les brokers détiennent sur vous.

En résumé il se charge automatiquement de contacter les centaines de

data brokers

qui ont potentiellement vos infos et gère pour vous les demandes de suppression, le suivi et les relances. Plus de 100 000 utilisateurs européens ont déjà lancé un grand ménage numérique via le service.

À partir de l’étude 2025 citées ci-dessus, Incogni insiste sur : la transparence totale sur la collecte/traitement des données, la possibilité de retirer très simplement ses données de nombreuses bases (sous réserve de législation locale, bien sûr) et recommande d’éviter celles qui n’offrent aucune clarté ou option d’opt-out. Cela dit ce n’est pas magique : “effacer” sa présence totale en ligne reste presque impossible. Mais avec Incogni, vous pouvez drastiquement limiter la surface d’attaque pour les arnaqueurs et brokers.

L’avenir de la privacy face à l’IA

À mesure que l’IA progresse, la barrière entre vie privée et “open data” explose. Certains fournisseurs d’IA s’améliorent alors que d’autres assument un business model intégralement fondé sur la collecte et la redistribution de vos vies numériques.

La meilleure protection ? Rester informé (lisez mes news haha), lire les classements indépendants, choisir les outils qui offrent le maximum de contrôle et, pour tout ce qui a déjà “fuité”, passer à l’action avec des outils de nettoyage comme Incogni avant que le dentifrice soit vraiment partout…

Rappelez-vous : une requête innocente à ChatGPT, et c’est tout votre historique en ligne qui peut refaire surface. L’IA peut vous aider à trouver des infos, mais elle permet aussi aux escrocs… d’en trouver vous concernant. À méditer !

Leave a Comment